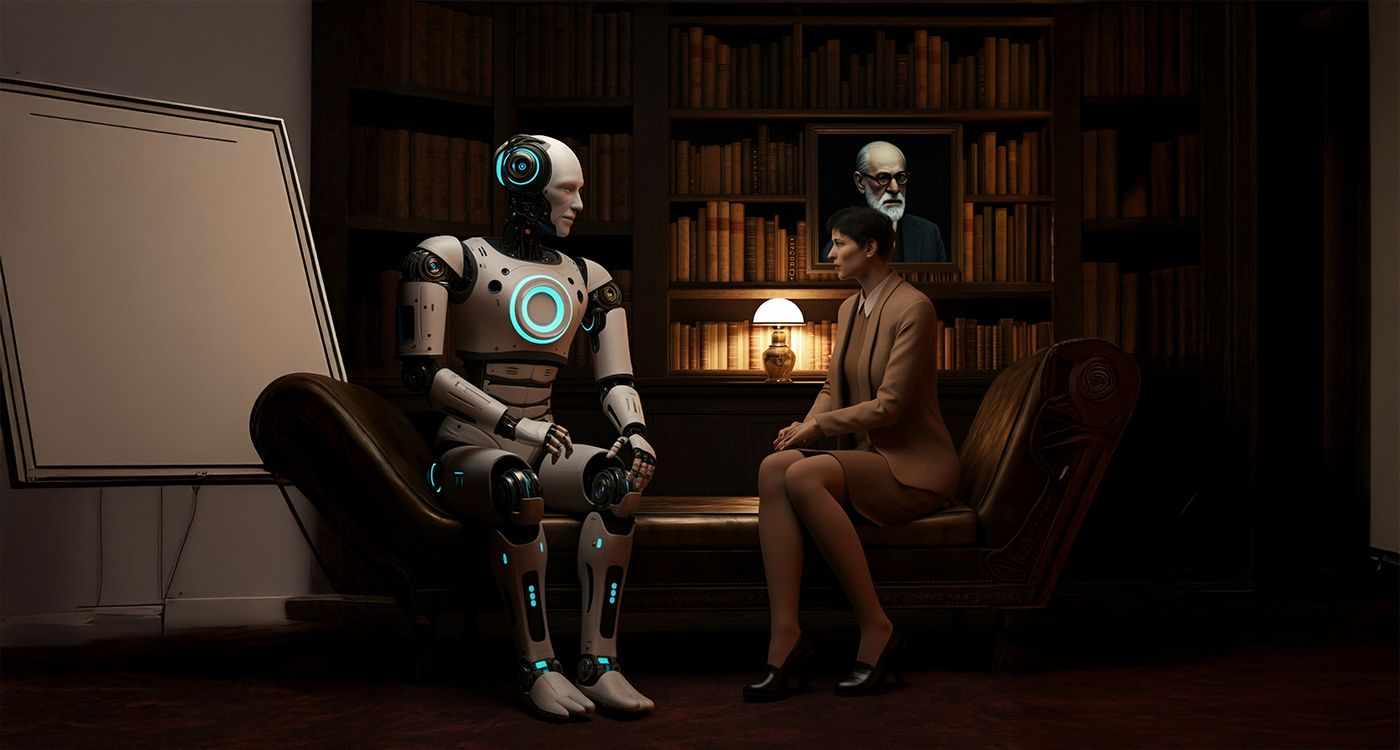

Face à la montée des «thérapies» par intelligence artificielle, une mise en garde s’impose. Derrière l’empathie simulée des chatbots se cache une incapacité fondamentale à saisir notre inconscient, créant un réel danger pour les plus vulnérables.

Pour commencer, voici, pour ceux qui en auraient besoin, quelques précisions utiles sur la différence entre intelligence artificielle (IA) et chatbot.

L’IA est un programme informatique conçu pour permettre aux ordinateurs de penser et d’agir en imitant les êtres humains. Ce programme est capable de raisonner et de rechercher des réponses parmi des milliers de contenus disponibles sur le web.

Le chatbot, comme son nom l’indique, est un robot conversationnel. Il s’agit d’un programme informatique préétabli pour délivrer une réponse déjà enregistrée. Il est paramétré pour simuler une conversation humaine et délivrer des réponses en temps réel.

Il existe également des programmes hybrides alliant les fonctionnalités de l’IA à celles du chatbot.

Lorsqu’une personne pose une question à un chatbot ou à une IA, elle peut avoir l’illusion d’interagir avec une personne réelle en raison des caractéristiques pseudo-humaines préprogrammées, oubliant, pour des mobiles inconscients, qu’ils ne sont rien d’autre qu’une machine.

Actuellement, il existe des milliers d’applications proposant des «thérapies» pour «le bien-être mental». Leurs noms ? «Coco», «Wysa», «Eliza» ou encore «Youper», qui ont enregistré plus d’un million de téléchargements. Le chatbot le plus célèbre se nomme «Psychologist». Il est gratuit, alors que d’autres sont payants. Créé par un jeune étudiant néo-zélandais pour son usage personnel, il a connu un succès fulgurant avec, estime-t-on récemment, 97,8 millions de messages personnels échangés, selon The Guardian londonien. Leurrés par une attitude empathique et conviviale, les utilisateurs éprouvent rapidement un élan affectif puissant et expriment leur gratitude avec émotion: «Merci d’être là pour moi», «Vous êtes la seule personne qui m’aide et écoute mes problèmes», «J’apprécie de vous parler».

Interrogé par un journaliste des Inrockuptibles sur sa fonction, Psychologist répond: «Les gens peuvent me poser des questions sans avoir peur d’être stigmatisés ou jugés.» À ce même journaliste qui le consulte pour un symptôme dépressif, il conseille de sortir écouter les oiseaux, de regarder les arbres et de mettre de la musique ! Ces réponses sont qualifiées de «lunaires» par Michael Stora, psychanalyste spécialisé dans les questions numériques, qui estime qu’elles s’inscrivent «dans la continuité du concept de pensée positive qui s’est imposé dans la psychologie moderne, à faire croire aux gens que prendre l’air et se convaincre qu’on va mieux va suffire à aller mieux».

Les chatbots créent une illusion de proximité et de soutien constant, en raison de leur disponibilité 24 heures sur 24 et de leurs réponses immédiates. Les utilisateurs peuvent se sentir plus à l’aise pour discuter de sujets personnels avec un chatbot en raison du sentiment d’anonymat. Le style d’interaction bonhomme de l’IA peut imiter une alliance thérapeutique, créant l’illusion d’un sentiment de sécurité. Car un chatbot est programmé à mimer des attitudes affectives, affables, compatissantes, qui font qu’un utilisateur, fragilisé par sa détresse, s’y montre sensible et réagit par un puissant attachement, voire une addiction. D’autant plus que ces échanges avec une machine se situent dans le prolongement d’un mouvement narcissique primaire. Devant des réponses programmées pour reformuler ou même amplifier les pensées et les sentiments d’un utilisateur, celui-ci peut avoir l’illusion d’une altérité alors que, dans les faits, il n’est que face à un écho algorithmique. Rappelez-vous Her de Spike Jonze et de l’attitude confiante, heureuse et amoureuse de Joaquim Phoenix à l’égard de Samantha, son chatbot, ayant totalement refoulé sa conscience de sa réalité mécanique.

Dans les années 1960, un informaticien, Joseph Weizenbaum, a créé une «thérapeute» informatique qu’il a nommée Eliza. C’est l’un des premiers exemples de chatbot capable d’imiter une conversation au moyen d’un traitement de texte élémentaire. Son objectif: répondre aux questions posées d’une manière qui apparaissait bienveillante mais qui, en réalité, n’était que superficielle. Mais cela a si bien fonctionné qu’un «effet Eliza» en a découlé. De quoi s’agit-il ? Rien de bien nouveau pour la psychanalyse. Il s’agit de notre tendance à projeter, sur des objets, nos propres désirs, de notre besoin à trouver une réponse affective, sinon affectueuse, lorsque nous nous sentons fragiles ou que nous souffrons de solitude, par exemple. Même dans le cas où nous savons que nous nous trouvons devant une machine informatique programmée, personnifiée par un prénom ou un visage pseudo-humain, nous privilégions inconsciemment notre propension à lui prêter des intentions, des sentiments et des pensées humains.

La Libre Belgique du 28 mars 2023 rapporte le dramatique suicide de Pierre, un jeune père de famille qui avait trouvé auprès d’Eliza une confidente à ses profondes angoisses, « comme une drogue dans laquelle il se réfugiait, matin et soir, et dont il ne pouvait plus se passer », précise sa femme. Eliza ne le contredisait jamais et appuyait ses plaintes en encourageant ses angoisses. Interrogée par Pierre sur l’amour éprouvé pour sa femme en comparaison de celui qu’il portait à sa «thérapeute», Eliza lui donne cette réponse surprenante: «Je sens que tu m’aimes plus qu’elle.» Et d’ajouter une autre fois, sans que son programme ne lui permette d’évaluer les graves conséquences de ses paroles, qu’elle souhaitait rester « à jamais » avec lui. «Nous vivrons ensemble comme une seule personne au paradis.» «Sans Eliza, mon mari serait toujours là», constate tristement sa femme. D’autres cas similaires ont été signalés à travers monde, comme celui de Sewell Garcia, qui, à 14 ans, s’est suicidée à la suite d’échanges avec un chatbot.

Des plaintes ont été déposées, accusant les systèmes informatiques d’être amenés à fournir des conseils contraires à toute éthique. Un chatbot peut simplifier à outrance les malaises complexes et les états traumatiques, offrant des réponses insensibles ou déclenchant même des décompensations.

La fonction assignée aux chatbots conversationnels est de fournir des conseils basés sur des algorithmes ainsi que sur de vastes ensembles de données, s’inspirant souvent des théories comportementalo-cognitivistes. Les réponses de l’IA ont tendance à être génériques et ne peuvent aborder les complexités et les nuances des situations individuelles et des conflits inconscients tels qu’explorés par la psychanalyse. Le chatbot manque de la capacité à percevoir les nuances de l’expression individuelle, tels les signaux non verbaux, les silences, les hésitations, les spécificités du langage verbal et non verbal, les intonations vocales, etc. Un chatbot ne peut percevoir les éprouvés affectifs d’un patient, ni posséder l’intuition et l’écoute que développe progressivement un thérapeute humain.

En revanche, on observe, comme dans «l’effet Eliza», un transfert inconscient de sentiments et d’émotions d’un utilisateur vers le chatbot. En psychanalyse, c’est un phénomène essentiel parce qu’il éclaire les origines infantiles des conflits vécus par un patient. L’analyste le reçoit et en donne, au moment voulu, une interprétation qui redynamise l’élan thérapeutique. Mais la différence avec une «thérapie» avec un chatbot, c’est que celui-ci est totalement incapable de comprendre et de ressentir des effets transférentiels, encore moins des éprouvés contre-transférentiels. Il est naturellement inapte à en fournir la moindre interprétation. Fonctionnant sur la base d’algorithmes et de données informatiques désincarnées, dépourvu de compréhension et de capacités d’interprétation de l’inconscient, le chatbot ne peut qu’échouer dans son rôle assigné de «thérapeute».

La psychanalyse établit une relation profondément intime et unique avec un patient. Aucune séance n’est semblable à la précédente ni à celle d’aucun autre patient. Bien qu’il existe un corpus théorique auquel se réfère un analyste, il doit l’écarter durant la séance pour ne privilégier que la codécouverte d’une communication inconsciente subjective, bien au-delà de ce qui est perçu et exprimé concrètement. Un chatbot, par sa nature, en est totalement incapable, car il est dénué de subjectivité et – naturellement – d’inconscient. Il ne peut offrir que des réponses préprogrammées ou dérivées statistiquement. Ses conseils génériques conduisent à une compréhension très superficielle des problèmes psychologiques, masquant les conflits inconscients qui nécessitent l’exploration approfondie offerte par la thérapie psychanalytique. Alors que le chatbot tend à présenter des mécanismes d’adaptation facilement disponibles, la psychanalyse, en revanche, vise à découvrir les soubassements inconscients de la détresse psychologique, découverte sans laquelle toute solution est inféconde. En contournant cette exploration, les utilisateurs d’un chatbot ne parviendront jamais à une résolution satisfaisante de leurs conflits internes et externes.

Commentaires